Carlos Gershenson

Facultad de Filosofía y Letras

UNAM

cgg unam.mx

unam.mx

marzo-abril, 2001.

Resumen

La Inteligencia Artificial proporciona medios invaluables para la comprensión de la mente. Revisamos el camino que ha recorrido (y pretende recorrer) la Inteligencia Artificial, y sus repercusiones sobre el concepto de la mente, y su relación con el cuerpo.

Índice

Introducción 2

La mente desincorporada 2

¿Qué podemos entender por inteligencia? 4

La mente incorporada 4

Evolución de la Cognición 5

Sistemas Complejos 6

Conclusiones 8

Agradecimientos 9

Referencias 9

Al parecer, desde que el hombre obtuvo conciencia del poder de su mente se ha preguntado por su procedencia y funcionamiento. ¿Pero cómo estudiar a la mente, si para comprender algo utilizamos a la mente misma? ¿Cómo se puede ver la mente a sí misma? Se requiere de un espejo. La primera alternativa es utilizar como espejo la mente de los demás, desde la cual se formó la psicología. A su vez, la neurofisiología estudia el funcionamiento de las neuronas y el cerebro, para tratar de comprender de dónde proviene la mente. En los últimos cincuenta años ha nacido otra alternativa: utilizar sistemas artificiales como espejo para comprender a nuestra propia mente: la inteligencia artificial. De estas tres disciplinas, y de otras tales como las matemáticas, la física, la filosofía, la lingüística y los sistemas complejos, las ciencias cognitivas se nutren para atacar desde todos los ángulos posibles el problema de descubrir qué es la mente y cómo funciona.

En este trabajo nos enfocaremos principalmente a los estudios hechos desde el espejo de la Inteligencia Artificial, la cual, para tratar de comprender a la mente, desarrolla sistemas artificiales que simulan la inteligencia que exhiben sistemas naturales en su comportamiento. Los sistemas inteligentes artificiales proporcionan una "muleta" para poder pensar a la mente. Muleta la cual es necesaria para nosotros, inválidos que somos en el proceso de comprendernos a nosotros mismos.

En la siguiente sección, discutimos cómo percibía a la mente la Inteligencia Artificial en sus inicios, para después discutir acerca del concepto de inteligencia. Después expondremos el cambio de perspectiva que ha hecho la Inteligencia Artificial en los últimos veinte años, para después poder hablar de la evolución de la cognición. Finalmente, exponemos ideas básicas de la teoría de los Sistemas Complejos, las cuales complementan la visión de la mente desde la Inteligencia Artificial.

Descartes, al no poder comprender la complejidad de la mente a partir de las "simples" interacciones del cuerpo, concluyó que ésta era independiente del cuerpo (tal vez también por motivos religiosos), motivo por el cual en el universo había dos tipos de substancias: la material y la espiritual; relacionadas entre sí, pero no explicables una desde la otra. Schopenhauer hace una distinción similar entre sujeto y objeto.

Es curioso que la Inteligencia Artificial en sus orígenes, a mediados del siglo XX (ya se habían contemplado previamente las posibilidades de máquinas "inteligentes", pero fue sólo con el advenimiento de las computadoras digitales que esto se pudo empezar a concretar), también contempló a la mente como un ente aislado del cuerpo, por lo cual se empezaron a desarrollar sistemas que tenían una perspectiva de la mente como un ente aislado del mundo. Estos sistemas se enfocaron a simular precisamente lo que la mente hace sin necesidad del cuerpo: razonamientos lógicos, solución de problemas, juegos mentales, entre otros. A estos sistemas se les llegó a conocer como sistemas basados en el conocimiento.

Fue cuando se quiso simular desde esta misma perspectiva procesos que involucran al cuerpo, tales como la coordinación motriz, la navegación autónoma y la supervivencia en un medio ambiente complejo e impredecible, que los sistemas basados en el comportamiento empezaron a fallar (porque simulan de forma bastante efectiva los procesos "abstractos" de la mente (como recientemente lo demostró la computadora Deep Blue, al derrotar al ex campeón mundial de ajedrez Gary Kasparov)).

Además de esto, el llamado problema del cuarto chino (Searle, 1980) puso en jaque a la validez de la inteligencia artificial. El argumento del cuarto chino es el siguiente: colocamos a un inglés (que no comprende el chino) en un cuarto cerrado, donde se encuentran símbolos en chino, e instrucciones en inglés de cómo manipular estos símbolos. Por una rendija, científicos chinos le dan al inglés instrucciones en chino, las cuales no comprende, pero guiándose por las instrucciones que tiene en inglés, manipula los símbolos que tiene en el cuarto de forma tal que obtiene una respuesta correcta en chino. La situación es la siguiente: el inglés da la respuesta correcta, tal como lo haría una computadora con "supuesta inteligencia", pero no es consciente de qué fue lo que hizo. Por lo tanto, las máquinas no pueden tener inteligencia, sólo es una farsa de ella.

Muy bien. El argumento del cuarto chino suena muy convincente, tanto, que ¿por qué no lo aplicamos a nosotros mismos? Por ejemplo: uno puede manejar un automóvil sin necesidad de saber mecánica. ¿Por esta razón no puede manejar? Creo que no. Los niños pueden manejar computadoras sin la necesidad de tener conocimientos profundos acerca de microprocesadores. No necesitamos saber qué es el amor para poder amar, ni necesitamos saber qué es la vida para poder vivir. ¿Cómo podemos pretender juzgar a una inocente computadora si tiene inteligencia o no porque no sabe qué es lo que hace, si nosotros tampoco sabemos cómo funciona nuestra mente? Dado que no sabemos precisamente qué es la mente, ni cómo funciona, no podemos utilizar este criterio para valorar la inteligencia en máquinas u otros animales.

Si no podemos comprender el funcionamiento de nuestra inteligencia, sólo podemos juzgar la inteligencia a partir de las acciones. Turing (1950) propuso una prueba para determinar la inteligencia en una máquina. Simplificando, sería esta: una persona interroga a un hombre y a una máquina, los cuales están aislados del interrogador. Si el interrogador confunde a la máquina con un hombre, esta máquina es inteligente. Nótese que no importa cómo funcione la máquina, con tal de que reproduzca el comportamiento humano.

Vemos que esta prueba depende del criterio del interrogador, quien juzga si las respuestas son satisfactorias o no. Extendiendo esta prueba, y basándonos en las ideas del Dr. Mario Lagunez, podemos decir que para que un sistema (hombre, animal, máquina) sea considerado inteligente, éste tiene que realizar una acción. Después, una tercera persona juzga si la acción fue ejecutada de una forma inteligente o no. Como vemos, un sistema puede ser inteligente para algunos y para otros no. No importa. Lo que queremos dejar claro es que la inteligencia es percibible sólo en el comportamiento de los sistemas.

La inteligencia no se tiene, se exhibe.

A mediados de la década de los ochentas, los investigadores en Inteligencia Artificial se dieron cuenta de esto mismo. Vieron que la inteligencia que los sistemas basados en el conocimiento no podían simular era innata en todos los animales, los cuales pueden adaptarse a su medio ambiente impredecible. Es por esto que empezaron a modelar sistemas inteligentes inspirándose en el comportamiento animal, dando cabida a los sistemas basados en el comportamiento.

Un animal exhibe inteligencia en su comportamiento adaptativo. De la misma forma, un sistema se considerará inteligente si puede adaptarse a su medio. Cómo lo haga no es la cuestión principal. Los sistemas basados en el comportamiento han probado su eficacia hasta cierto nivel de complejidad: han simulado de forma satisfactoria ciertos comportamientos de insectos y de algunos mamíferos, y el comportamiento característico de una gran variedad de animales. Y las propiedades inteligentes de estos sistemas, tanto naturales como artificiales, devienen directamente del cuerpo. Es decir, los mecanismos neuronales, y su relación con el resto de cuerpo, y su relación con el medio ambiente, son suficientes para que el sistema se adapte, exhibiendo inteligencia.

Al ver en la línea de la evolución, primero encontramos al comportamiento adaptativo, y después el conocimiento y razonamiento abstracto. ¿Cómo evolucionó el cuerpo para poseer una mente como la nuestra a partir del comportamiento adaptativo? ¿Cómo adquirió esta capacidad de introspección y raciocinio? Estas son otras preguntas que los sistemas basados en el conocimiento no han podido responder, pero que los sistemas basados en el comportamiento empiezan a atacar (Gershenson, 2001).

Para comprender y para simular a la mente no sólo hay que preguntarse qué es y dónde se encuentra, sino también cómo llegó ahí. Es por esto que nuestro interés se enfoca hacia la evolución de la cognición.

Suponemos que el hombre evolucionó de animales con un menor desarrollo intelectual. No creemos que la mente se haya obtenido instantáneamente, sino por medio de largos procesos evolutivos. Primero, la selección natural determina que sobrevivan especies capaces de adaptarse a su medio. Mientras mejor se adapten, podríamos considerarlas más inteligentes. Ciertas especies, dependiendo de varias condiciones, se organizan en sociedades. Al formarse sociedades, para poder lograr fines comunes, se desarrollan medios de comunicación: lenguajes, tales como podemos percibir en insectos sociales (e.g. hormigas con feromonas, abejas con "bailes") y en varios vertebrados (e.g. ballenas con cantos, una multiplicidad de expresiones relacionadas con el apareamiento). Para que haya lenguajes, ya debe de haber ciertas construcciones conceptuales. Los conceptos se forman simplemente al repetirse una experiencia. Cuando se tiene un lenguaje se le puede asignar un nombre al concepto. Los conceptos pueden hacerse más y más abstractos, y el lenguaje permite que los conceptos sean transmitidos y discutidos. El lenguaje permite que los conceptos puedan sobrevivir a través de generaciones y evolucionar. Estos conceptos representan conocimiento. Es la acumulación del conocimiento lo que permite que se forme una cultura. La cultura retroalimenta al individuo, el cual puede desarrollar capacidades cognitivas facilitadas por la cultura.

Nosotros no somos muy distintos genéticamente a los hombres que cruzaron el estrecho de Bering hace alrededor de diez mil años. Pero intelectualmente, los avances en el último siglo han sido impresionantes. Estos avances se dan por la evolución cultural, no sólo por la natural.

Es claro que físicamente se requiere de un organismo que tenga capacidades cognitivas. Pero uno no nace con mente. La mente se forma dependiendo del medio con el cual tenga que contender.

Si queremos comprender y simular la mente, tenemos que comprender y simular todo el camino que la mente ha recorrido.

Los sistemas complejos ofrecen otro punto de vista desde el cual comprender la relación entre la mente y el cuerpo, por lo cual los expondremos a continuación.

No hay una definición precisa de "sistema complejo", y de hecho hay más de setenta definiciones de complejidad. Pero podemos decir que un sistema es más complejo mientras más elementos tenga, mayores interacciones haya entre ellos, y mayores sean las complejidades de los elementos y de las interacciones. Los sistemas complejos presentan propiedades emergentes. Una propiedad emergente no se encuentra en las partes del sistema, pero sí en el sistema mismo. ¿De dónde salen las propiedades? De las interacciones entre los elementos.

Por ejemplo, parvadas, manadas y cardúmenes tienen comportamientos como sistema que los individuos que los conforman no pueden presentar por sí mismos. Estos comportamientos sociales emergen de la interacción entre los individuos. Otro ejemplo lo podemos ver en una célula. Ésta es "sólo" un grupo de proteínas y moléculas ordenadas de una forma muy interesante. Pero no decimos que las proteínas (ni aún los priones) o las moléculas están vivas, y la célula sí. ¿De dónde sale la vida? Emerge. Por otro lado, las palabras por sí mismas tienen poco significado, si se compara con el que puede emerger al combinarlas de formas que los grandes literatos comprenden mejor que nosotros.

De forma similar, una neurona no tiene inteligencia. Pero billones de neuronas interactuando entre sí pueden dar cabida a algo que llamamos mente, la cual es emergente. Es por esto, que la inteligencia artificial también busca simular una mente emergente, a partir de componentes más simples los cuales no se consideran inteligentes (e.g. Minsky, 1984).

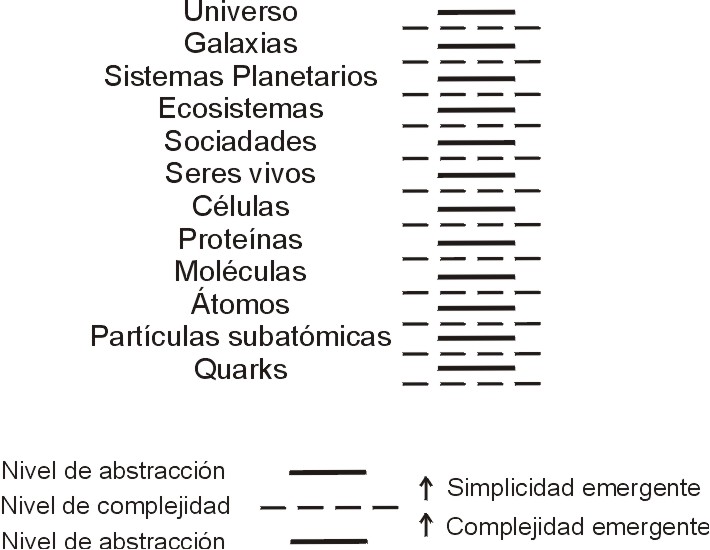

Muy bien. Podemos definir como niveles de abstracción a los niveles donde podemos identificar un sistema simple (sin propiedades emergentes, porque el sistema es compuesto por un elemento el cual no interactúa con otros. Todas las propiedades del sistema las posee también como elemento único del sistema). Al empezar a interactuar diversos sistemas simples, se empiezan a formar sistemas más y más complejos, hasta que la ciencia actual no puede predecir computacionalmente el comportamiento del sistema. A este fenómeno se el conoce como complejidad emergente. Pero después, dentro de un sistema empieza a haber regularidades, se autoorganiza, y al percibir de nuevo fenómenos repetitivos, podemos asociarlos a un concepto, nombrarlos, describirlos, y comprenderlos, porque el sistema resultante se ha hecho simple, debido a una simplicidad emergente. Y al interactuar los sistemas simples vuelven a presentar complejidad emergente.

Podríamos decir que uno de los objetivos de la ciencia será el tratar de cerrar las brechas entre distintos niveles de abstracción. Si podemos comprender un nivel de abstracción a partir del nivel inferior, ¿qué tanto quedará del nivel de abstracción por comprender? Bueno, esto, parafraseando a Herbert Simon, que en paz descanse, no pretende explicar "ovejas en términos de quarks". No es que un quark no pueda afectar el comportamiento de una oveja, pero su efecto se percibe en todos los niveles de abstracción que se cruzan.

Los sistemas complejos explican cómo es que se pueden formar propiedades y fenómenos nuevos (emergentes), al interactuar los elementos de un sistema. Estas propiedades no salen de la nada por no estar en los elementos. Salen de las interacciones entre ellos. De esta forma, se puede explicar a la mente emergiendo de muchas interacciones a distintos niveles: entre las neuronas del sistema nervioso, entre el individuo y su mundo, entre distintos individuos, entre el individuo y su sociedad, y entre el individuo y su cultura.

No sólo en la mente, las propiedades emergentes no es que no estén ahí, sino que dependen de los elementos del sistema. ¿Cómo podemos ver una interacción? La interacción no tiene materia en sí, pero el una propiedad que podemos percibir, como tantas otras, al ver dos o más elementos interactuando en un sistema. Finalmente, parece ser que el mundo está compuesto más de propiedades que de materia, ya que a los quarks se les ha llamado "los sueños de los cuales está hecha la materia". En otras palabras, sólo sabemos que los niveles de abstracción dependen de niveles de abstracción inferiores. Pero no conocemos un nivel de abstracción mínimo, el cual no tiene por qué dejarse encontrar (no hay una condición que me impida seguir dividiendo a un sistema). Todo está hecho de una infinitud de nadas.

Todos los niveles de abstracción son representados por propiedades que hacen su dinámica uniforme. Pero en sí, sólo podemos ver estas propiedades. La mente, de igual manera, es un conjunto de propiedades que podemos percibir.

Quisiera agradecer a José Negrete, a Pedro Pablo González, y a Nadia Bazlova por las interesantes y fructíferas conversaciones acerca del tema.

Gershenson, C. (2001). Artificial Societies of Intelligent Agents. Tesis de Ingeniería en Computación, Fundación Arturo Rosenblueth, Ciudad de México.

Minsky, M. (1984). The Society of Mind. Simon & Schuster, New York.

Searle , J. R., (1980). Minds, brains and programs. Behavioral and Brain Sciences 3:417-57.

Turing, A. M. (1950). Computing Machinery and Intelligence. Mind, LIX (236), pp. 433-460.

NOTA: Las referencias del autor pueden encontrarse en https://bingweb.binghamton.edu/%7Ecgershensong/unamjlagunez, junto con otros recursos relacionados.